AeC é eleita Empresa do Ano pela Frost & Sullivan pelo quarto ano consecutivo

Reconhecimento destaca inovação digital, excelência operacional e estratégia centrada no cliente da companhia brasileira

A recente liberação pública do chatGPT, que foi a primeira vez que muita gente teve contato direto com IA criou um verdadeiro frenesi. De um dia para o outro passou…

Adnews

20.03.2023

A recente liberação pública do chatGPT, que foi a primeira vez que muita gente teve contato direto com IA criou um verdadeiro frenesi. De um dia para o outro passou a ser notícia até de jornais diários e surgiram os “experts” em “generative AI” publicando artigos rasos e criando canais e cursos no Youtube. E curiosamente, muitos ficaram com a percepção que o chatGPT surgiu de geração espontânea, como uma inspiração genial de um dia para o outro.

Não é assim. E aliás, não foi a primeira vez na história da evolução da IA que esse entusiasmo aconteceu. A primeira onda de entusiasmo correu logo após a criação do próprio termo “Inteligência Artificial” em 1956. Ele surgiu durante um workshop de verão organizado por quatro pesquisadores norte-americanos — John McCarthy, Marvin Minsky, Nathaniel Rochester e Claude Shannon — na Universidade de Dartmouth, em New Hampshire, Estados Unidos. Para termos uma ideia de quão limitada era a capacidade computacional na época, o IBM 1401, lançado em 1959, tinha o máximo de 16K de memória. Mas, os pesquisadores viram o potencial dessas máquinas e em 1958, Herbert Simon e Allen Newell escreveram: “dentro de dez anos, um computador digital será o campeão mundial de xadrez” e “dentro de dez anos, um computador digital descobrirá e provará um importante novo teorema matemático”. Em 1960, Herbert A. Simon afirmou “máquinas serão capazes, dentro de vinte anos, de fazer qualquer trabalho que um homem pode fazer”. O entusiasmo era grande e em 1967, Marvin Minsky previu que “dentro de uma geração. . . o problema de criar ‘inteligência artificial’ será substancialmente resolvido.” E logo após, em 1970, ele em entrevista à Life Magazine, afirmou: “Em três a oito anos teremos uma máquina com a inteligência geral de um ser humano médio”.

Em 1963 o Departamento de Defesa dos EUA investiu mais de 2 milhões de US$ em um projeto de IA cujo objetivo seria fazer a tradução automática do russo para o inglês, uma vez que o mundo vivia o auge da Guerra Fria entre EUA e a então URSS. Alguns anos depois mais 15 milhões de US$ forma investidos pelo governo americano para um projeto de IA que permitisse que computadores entendessem comando verbais, de modo que os soldados não tivessem que operar manualmente equipamentos militares. No decorrer da década, entretanto, os resultados mostraram que nada disso aconteceria e os investimentos e pesquisas praticamente cessaram. Esse foi o chamado primeiro inverno da IA.

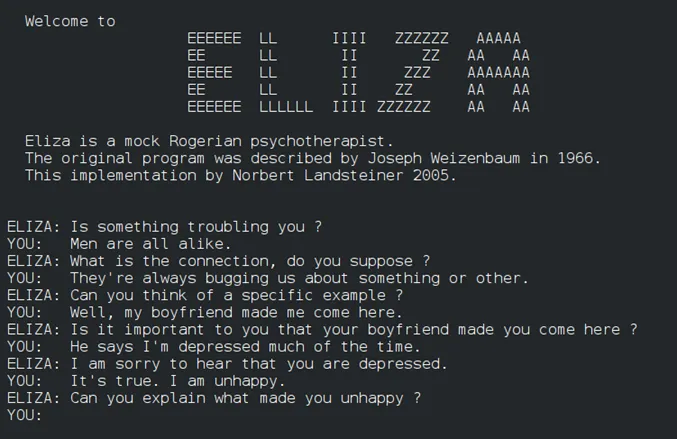

Mas, em torno de meados dos anos 80, surgiu outra onda de interesse. Dessa vez foram os “expert systems”, que se propunha a simular o processo de raciocínio de um especialista. Esses sistemas baseavam-se em programação, onde o processo de raciocínio era decomposto em árvores de decisão e esse conhecimento era codificado em milhares de regras. Foi nessa época, que evoluindo na minha carreira profissional, me tornei um entusiasta da IA. Na adolescência devorava livros de Isaac Asimov, como a famosa trilogia “Fundação” e, principalmente, “Eu, robô”. “Eu, robô” foi uma série de contos que são um marco na história da ficção científica, pela introdução das célebres Leis da Robótica, e por um olhar completamente novo a respeito das máquinas. Os robôs de Asimov conquistaram a cabeça e a alma de gerações de escritores, cineastas e cientistas, sendo até hoje fonte de inspiração de tudo o que lemos e assistimos sobre eles. Depois veio o inesquecível filme de Stanley Kubrick, “2001, uma odisséia no espaço” e com ele o HAL 9000 (Heuristically programmed ALgorithmic computer), que é um computador com avançada inteligência artificial, instalado a bordo da nave espacial Discovery e responsável por todo seu funcionamento. Os diálogos dele com os atores me deixaram realmente impressionado com que o futuro poderia nos trazer. Quando li, no início dos anos 80, um paper sobre o Eliza, “ELIZA A Computer Program For the Study of Natural Language Communication Between Man And Machine”, publicado em 1966, software criado por pesquisadores do MIT, vi que a IA era possível sim, pois já nos anos 60 um sistema conseguia interagir de forma razoável com humanos. Comecei a ler todos os livros sobre o assunto e em meados dos anos 80, consegui aprovação para colocar em prática uma experiência, dentro da empresa na qual trabalhava.

Na época o cenário da IA estava dividido em duas linhas de pensamento, um grupo que adotava o conceito de “rule-based”, também chamado de “expert systems” ou sistemas especialistas, e o grupo que se orientava pelo conceito de redes neurais (neural networks). As redes neurais pareciam muito promissoras, mas faltavam dados e a capacidade computacional disponível era imensamente inferior à que temos hoje. Pragmaticamente optei pelos sistemas especialistas, pois a lógica de desenvolvimento me parecia mais factível: entrevistar profissionais especialistas em determinada área e codificar seus processos de decisão, em uma árvore de decisão, com If-Then-Else. Um sistema especialista tem dois componentes básicos: um motor de inferência e uma base de conhecimentos. A base de conhecimento tem os fatos e regras, e o motor de inferência aplica as regras aos fatos conhecidos e deduz novos fatos. Primeira dificuldade foi aprender a linguagem Lisp, mas vencida a barreira, a prática de buscar o conhecimento dos especialistas foi um entrave: por serem especialistas eram muito requisitados e não tinham tempo disponível, muito menos para um projeto experimental. Além disso, era muito dificil tentar traduzir suas decisões, muitas vezes intuitivas, em regras claras para serem colocadas na árvore de decisão. E à medida que ia acumulando conhecimento do especialista, o processo tornava-se mais e mais complexo. Em resumo, o sistema nunca funcionou adequadamente e foi descontinuado. Mas valeu a experiência.

Mas, muita gente se entusiasmou com isso. Era o “hype” do momento. Nasceram projetos “moon shot” como o “Fifth Generation Computer Systems” do Japão. Esse foi um projeto gigantesco de pesquisa governamental e industrial no Japão durante a década de 80. Seu principal objetivo a criação de um computador que “marcasse uma época” com performance semelhante a um supercomputador e capacidade prática de inteligência artificial. O termo “quinta geração” tentava mostrar o novo sistema como sendo um salto para além das máquinas já existentes. Foi um fracasso milionário, com mais de 400 milhões de US$ investidos. Os EUA não ficaram atrás e foram lançados projetos bilionários de carros e aviões autônomos. As principais empresas de tecnologia entraram na onda e investiram pesadamente em IA (os tais “expert systems”), como a DEC (Digital) que posteriormente foi comprada pela Compaq, que chegou a ter mais de 700 funcionários dedicados a projetos de IA.

Empresas (as startups) da época como a Symbolics e a Lisp Machine levantaram altos investimentos, mas depois de alguns anos faliram. O problema com os “expert systems” é que o mundo real é muito confuso e cheio de nuances para ser gerenciado de uma maneira muito lógica e programada. Os “sistemas especialistas” funcionaram bem até que a realidade os atingisse. Uma empresa de cartão de crédito, poderia criar um sistema para aprovar automaticamente solicitações de cartões, apenas para descobrir que emitia cartões para cães ou crianças de 13 anos. Os programadores nunca imaginaram que menores de idade ou animais de estimação solicitariam um cartão, então nunca escreveram regras para acomodar esses casos extremos. Tais sistemas não poderiam aprender uma nova regra por conta própria. A IA construída por meio de regras escritas formalmente em código era “frágil” e quando se deparava com uma situação estranha, simplesmente falhava. No início dos anos 90, esses problemas com os sistemas especialistas acabou com o entusiasmo, e os investimentos e pesquisas novamente secaram. Começou o segundo inverno da IA.

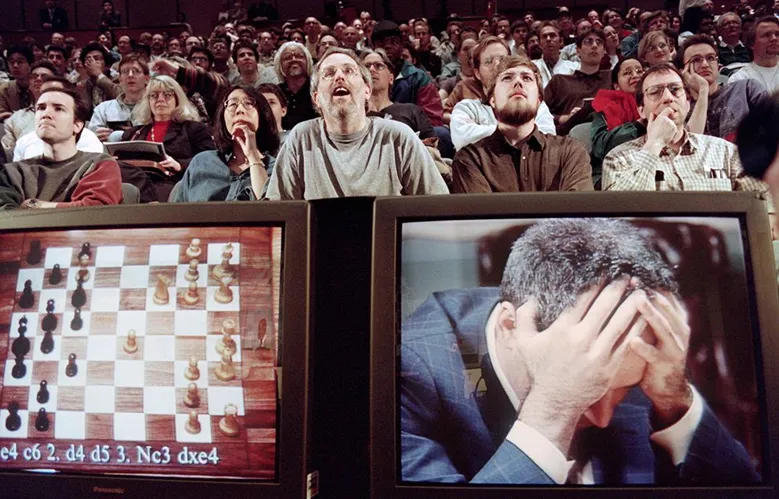

Esses invernos desestimularam o mercado, pesquisadores e investidores. E pouca coisa andou nos anos 90, è exceção de Deep Blue, da IBM, que conseguiu vencer o então campeão mundial de xadrez, Garry Kasparov, em 1997.

O Deep Blue calculava 200 milhões de posições por segundo para então escolher a que tinha maior probabilidade de ganhar. Uma curiosidade. O 44º lance, decisivo, executado pelo Deep Blue, confundiu totalmente Kasparov por ser absolutamente contraintuitivo. Era um movimento inesperado, sem qualquer razão de ser. Não era estratégico, nem ofensivo e nem defensivo. Kasparov sabia que tinha a capacidade de calcular até 15 lances adiante. E, como não viu sentido naquele lance, incorretamente deduziu que o Deep Blue podia antever jogadas mais do que ele próprio. E aí se desequilibrou emocionalmente pelo resto do match. Os programadores do DeepBlue também não entenderam o que aconteceu naquele momento e concluíram que era algo de menor importância e que poderia ser ajustado mais tarde. Só anos depois concluíram que, na verdade, o estranho movimento foi efeito de um bug.

O artigo “What the history of AI tells us about its future” mostra um pouco dos bastidores de como as coisas aconteceram. A IBM se beneficiou de frenesi da imprensa que se seguiu ao sucesso do Deep Blue, e o valor de mercado da empresa subiu US$ 11,4 bilhões em uma única semana. Ainda mais significativo, porém, foi que o triunfo da IBM pareceu um degelo no longo inverno da IA. Se o xadrez pudesse ser conquistado, o que viria a seguir? Mas, o frenesi durou pouco. A maioria das pessoas que prestava atenção à IA — e ao xadrez — esperava que isso acontecesse eventualmente. O xadrez pode parecer o ápice do pensamento humano, mas não é. Na verdade, é uma tarefa mental bastante passível de computação por força bruta: as regras são claras, não há informações ocultas e um computador nem precisa acompanhar o que aconteceu nos movimentos anteriores. Ele apenas avalia a posição das peças no momento. A vitória do Deep Blue foi o momento que mostrou que os sistemas codificados à mão (Os “expert systems”) são limitados. A IBM gastou anos e milhões de dólares desenvolvendo um computador para jogar xadrez. Mas não poderia fazer mais nada com ele. Só sabia jogar xadrez. Não se falou mais em IA.

A IA só veria renascimento com os sistemas de machine learning/deep learning a partir de 2010. Tivemos o Watson da IBM vencendo o Jeopardy em 2011, que foi um marco na evolução da IA. O artigo “How IBM Watson works” apresenta uma boa visão de como ele foi desenvolvido. O Watson representou o pico do uso do Raciocínio Probabilístico, bem como um dos últimos sistemas bem-sucedidos a usá-lo antes que o Deep Learning se tornasse a principal solução para a maioria dos problemas de Machine Learning. Para quem quer mergulhar mais a fundo no Watson, sugiro ler “Analysis of Watson’s Strategies for Playing Jeopardy!”.

Um dos maiores marcos em DL foi o AlphaGo da DeepMind, que venceu o campeão mundial de Go, “AlphaGo Wins Game One Against World Go Champion”. A importância do feito é descrito por Kai Fu Lee como tendo gerado o “momento Sputnik” para a China, que começou a investir pesado no jogo da IA. “A história do Go, que se crê ter sido inventado há mais de 2500 anos, estende‑se para tempos mais longínquos do que a de qualquer outro jogo de tabuleiro ainda jogado nos nossos dias. Na antiga China, o Go representava uma das quatro formas de arte que qualquer estudioso deveria ser capaz dominar. Acreditava‑se que o jogo imbuía os seus jogadores de um refinamento e sabedoria de tipo Zen. Enquanto jogos como o xadrez do Ocidente são friamente táticos, o jogo Go baseia‑se no posicionamento paciente e num cerco lento, o que fez dele uma forma de arte, um estado de espírito. A profundeza da história do Go encontra correspondência na complexidade do próprio jogo. As regras básicas da forma de jogar podem ser expostas em apenas nove frases, mas o número de posições possíveis num tabuleiro de Go excede o número de átomos no universo conhecido. A complexidade do leque de decisões possíveis fizera com que derrotar o campeão mundial de Go se tornasse numa espécie de Monte Evereste para a comunidade da inteligência artificial”.

A partir daí seguiu-se uma febre de investimentos em startups de IA (colocar ponto.ai no nome valorizava a startup) e começou-se a ver muita coisa aparecendo, em todos os setores de indústria. Afinal, já temos os dois fatores essenciais para fazer sistemas de DL: capacidade computacional disponível e abundância de dados. Em capacidade computacional, um simples smartphone tem mais poder computacional que um supercomputador Cray-2 de dez milhões de dólares de 1985. E na retaguarda deste smartphone temos nuvens computacionais com capacidades quase infinitas.

Claro que na esteira do entusiasmo, surgiram muitas previsões ambiciosas. Em 2020, Elon Musk disse “Elon Musk claims AI will overtake humans ‘in less than five years’”. Isso disparou, alguns anos atrás um grande otimismo com a aplicação da IA. E esse otimismo escondia a realidade que colocar projetos em IA é muito mais difícil e trabalhoso que se pensava no início. Em 2016, a PwC (Sizing the prize :PwC’s Global Artificial Intelligence Study: Exploiting the AI Revolution) fez projeções que o impacto econômico da IA no mundo chegaria a US$ 15,7 trilhões em 2030. Para 2020 chegaria a US$ 1,2 trilhão. Não havia sinais de pandemia no horizonte de 2016, claro, mas o impacto estimado chegou apenas a US$ 17 bilhões e os ajustes agora apontam que para 2025 chegará a 37 bilhões de dólares. Será muito pouco provável que em 2030 cheguemos perto do número mágico de mais de 15 trilhões de dólares.

Um artigo publicado na Quartz em 2021 (AI has a long way to go before doctors can trust it with your life) mostra que o caminho é muito pedregoso. Por exemplo, na área de radiologia, que o próprio Geoffrey Hinton, um dos padrinhos do Deep Learning, declarou em 2016 “devemos parar de formar radiologistas, pois é completamente óbvio que dentro de cinco anos, o DL será melhor do que os radiologistas”, e embora existam hoje mais de 80 algoritmos aprovados pelo FDA americano e outros tantos aprovados na Europa (Approval of artificial intelligence and machine learning-based medical devices in the USA and Europe (2015–20): a comparative analysis), a IA não substituiu esses especialistas. Nos EUA o número de radiologistas cresceu cerca de 7% entre 2015 e 2019. O que aconteceu? A IA foi superestimada. Imaginou-se que seria relativamente fácil fazer com que os algoritmos analisassem imagens com precisão. Na verdade, eles fazem isso, mas sua assertividade depende das imagens de treinamento e quando saem de um ambiente de testes, com imagens de alta qualidade e caem no mundo real, com imagens menos nítidas e protocolos diferentes dos quais aprendeu, sua taxa de acerto cai significativamente. Um estudo publicado na Radiology Business mostra que menos de 1/3 dos radiologistas americanos usam IA na sua atividade profissional (Only 30% of radiologists currently using artificial intelligence as part of their practice). Na verdade apenas 40 dos 80 algoritmos aprovados pelo FDA e mais 27 criados internamente em hospitais e clínicas estavam sendo usados. E desses, 34% eram usados para interpretação de imagens. Em resumo, apenas 11% dos radiologistas usavam IA para auxiliar a intepretação de imagens na sua prática médica. Dos que não usavam, 72% não tinham intenção de usar a curto ou médio prazo.

A principal razão é seu baixo desempenho. Menos de 6% disseram que a IA sempre funciona bem e 94% reportaram que o desempenho na assertividade é inconsistente e duvidoso. Andrew Ng foi sincero ao dizer “Those of us in machine learning are really good at doing well on a test set, but unfortunately deploying a system takes more than doing well on a test set”. Vale a pena ler a entrevista dele (e ver a sua entrevista no vídeo de cerca de 1 hora) no artigo “Andrew Ng X-Rays the AI Hype”.

No mundo real, em todos os setores, há um claro gap entre os resultados obtidos nos testes e projetos proof-of-concept e no mundo real. Quem também reconheceu isso foi Sundar Pichai, CEO do Google quando em entrevista disse “Still early days of AI, real potential to come in place in 10–20 years”. Sua frase não é pessimista, como pode parecer à primeira vista, mas claramente uma percepção bem mais clara da realidade. Os projetos de IA são bem mais difíceis e onerosos de fazer que pareciam inicialmente.

E então, que vimos a liberação pública do chatGPT e logo após o chatBing. Realmente, quando vi e testei o chatGPT pela primeira vez fiquei impressionado. A impressão inicial foi um efeito “uau”, um “Momento Jurassic Park”, pois quando vi pela primeira vez o filme, em 1993 parecia que os dinossauros eram reais, existiam mesmo na Isla Nublar. Pipocaram milhares de artigos enaltecendo o chatGPT e até mesmo frases bombásticas como “This AI chatbot could have an impact as great as the iPhone, or even greater: ‘The potential societal implications of ChatGPT are too big to fit into one column. Maybe this is, as some commenters have posited, the beginning of the end of all white-collar knowledge work, and a precursor to mass unemployment’ que apareceu no artigo do NY Times “The Brilliance and Weirdness of ChatGPT”.

Mas, à medida que vamos testando a tecnologia sentimos que os sistemas LLM (IA generativa) como ChatGPT podem gerar textos sem sentido, que parecem extremamente sensatos à primeira vista. Com a empolgação, começamos a ver seu uso se disseminando explosivamente em inúmeras situações, de escrita de texto a substituição do Google por buscas na web. Esse excesso de confiança nos seus resultados, que na verdade reflete os dados com os quais eles foram treinados, os torna mais propensos a gerar entusiasmo e aumenta ainda mais seu uso desordenado.

Diante do uso explosivo do chatGPT e de seu uso em situações as mais diversas possíveis, a própria OpenAI publicou um tuíte que me chamou a atenção pois parece nitidamente um “legal disclaimer: “ChatGPT is incredibly limited, but good enough at some things to create a misleading impression of greatness. it’s a mistake to be relying on it for anything important right now. it’s a preview of progress; we have lots of work to do on robustness and truthfulness.”.

É provável que, ao longo do tempo, os sistemas LLM encontrem seu espaço adequado em aplicações significativas. Mas, enquanto estivermos na fase da empolgação, devemos ter um pouco mais de cuidado, pois ainda muitos detalhes e dúvidas precisam ser resolvidos. A comunidade de IA deve se esforçar para evitar cair no hype (mais uma vez…) e analisar com mais atenção seus efeitos colaterais e eventuais consequências indesejadas.

Assim, depois que o frenesi e entusiasmo com o chatGPT diminuírem, e pensarmos com mais clareza e racionalidade, devemos debater com seriedade aspectos ainda nebulosos como a possibilidade desses sistemas generativos inundarem a internet com conteúdo inadequado, e quebrarem aspectos de direito autoral e propriedade intelectual. Afinal, um pouco de ceticismo e menos empolgação juvenil nos ajudam a tomar decisões mais assertivas.

Matéria: Cezar Taurion

Cézar Taurion é investidor e mentor de startups de IA e membro do conselho de inovação de diversas empresas e associações. Foi Chief Evangelist da IBM Brasil e sócio-diretor e líder da prática de IT Strategy da PwC. É autor de doze livros e professor convidado da Fundação Dom Cabral.

Foto de Capa: vecteezy | naretsaiipan664144

Fique ligado aqui no Adnews! Por que pra gente, sair do óbvio, é tão óbvio quanto criar e transformar.

Reconhecimento destaca inovação digital, excelência operacional e estratégia centrada no cliente da companhia brasileira

Plataforma internacional de moda e inovação firma representação com o Adnews e conecta mercado brasileiro ao Global Fashion Week Talks Tour

Paciente foi submetido a um fechamento percutâneo da persistência do canal arterial (PCA); procedimento inovador e minimamente invasivo reforça a estrutura de alta complexidade da unidade

Aprenda algo novo todos os dias.

Assine gratuitamente as newsletters da Adnews.